Provavelmente, você veio até aqui por conta de nosso curso de Estatística básica no R e está em busca dos arquivos utilizados e dos materiais complementares que eu mostro ou menciono no decorrer das aulas. Abaixo, você poderá fazer o download destes arquivos.

Arquivo principal

Para acessar/baixar a base de dados, basta clicar aqui. O arquivo apresenta os dados em formato “separado por vírgulas” (csv). Isto implica que você deverá estipular esta configuração no software. Como falei durante as aulas, os dados utilizados são reais e foram frutos de uma pesquisa que coordenei e encontra-se publicadada:

Afonso Jr, A., Ferro, T., Anunciação, L., & Landeira-Fernandez, J. (2018). Aspects Related to Body Image and Eating Behaviors in Healthy Brazilian Undergraduate Students. Global Journal of Educational Studies, 4(1), 43. https://doi.org/10.5296/gjes.v4i1.12541.

O curso

Vídeo de Apresentação do curso.

Descrição: Aqui você descobrirá quem eu sou e minha área de pesquisa. Este vídeo é curto (e foi planejado para ser assim) e apresenta a motivação do curso.

Aula teórica 1: Conceitos fundamentais em pesquisa

-vídeo-

Descrição: Considero que os três conceitos que antecedem quaisquer técnicas estatísticas são: realidade e modelo, constantes e variáveis e frequências e distribuições. Não espere que outros professores concordem integralmente com este pressuposto, já que a diversidade teórica é bastante frequente – e importante – na acadêmica. Porém, acho pouco provável que alguém discorde da importância destes conceitos.

Aula prática 1: O tidyverse

-vídeo-

Arquivo utilizado durante a aula: estatistica_r_aula1

Slide utilizado durante a aula: Estatistica no R – Aula 1 tabelas e graficos

Descrição: O R é um programa fabulosos e por ser bastante flexível, existem diferentes caminhos de se responder às mesmas questões de pesquisa e de programação. É possível filtrar bases de dados por muitas formas, bem como é possível realizar interações dentro de uma base por múltiplos comandos. Particularmente, acho que a forma que o ecossistema tidyverse funciona é bastante lógica, simples e direta. Acredito que é também mais fácil o estudante generalizar os comandos utilizados dentro do ambiente tidyverse para os comandos nativos do R, do que o contrário. Desta forma, neste vídeo, já no ambiente R, você irá aprender os comandos principais para administrar bases e realizar análises descritivas (tabelas e gráficos).

Aula teórica 2: Nível de medida

-vídeo-

Material complementar: Stevens, 1946. On the Theory of Scales of Measurement.

Descrição: Ao medir uma determinada variável, temos quais são os procedimentos matemáticos que podemos fazer com elas. Enquanto algumas variáveis somente permitem que a gente conte sua frequência, outras possibilitam operações mais complexas, como aplicar log, verificar a variância, etc. Esta aula traz o panorama histórica sobre o conceito de nível de medida.

Aula prática 2: Qui quadrado e ODDS-RATIO

-vídeo-

Arquivo utilizado durante a aula: estatistica_r_aula2 EPIDEMIO

Arquivo complementar: sintaxe_complementar_qui_quadrado (Gráfico da distribuição Qui quadrado)

Slide utilizado durante a aula: Estatistica no R – Aula 2 qui quadrado

Descrição: Frequentemente, temos interesse em analisar duas variáveis conjuntamente para verificar uma possível associação entre elas. Neste caso, ao considerar duas variáveis, o espectro de possibilidades é este: duas variáveis contínuas (por exemplo, salário e idade), uma variável contínua e uma categórica (por exemplo, salário e sexo) ou duas variáveis categóricas (por exemplo, profissão escolhida e sexo). No primeiro caso, gráficos de dispersão são úteis para este propósito. Nos dois últimos, a construção de uma tabela de contingências serve não somente para visualizar uma possível relação, mas também para operacionalizar os testes estatísticos relacionados à tal pergunta. O teste Qui quadrado foi elaborado para verificar a associação entre duas variáveis categóricas e faz isso calculando a diferença entre o número observado de respostas em determinada categoria e o número esperado no caso de independência entre as variáveis. Por não responder a questões sobre parâmetros, como média ou variância, ele é considerado um teste não-paramétrico e não depende de uma análise da distribuição das variáveis para sua execução.

Em epidemiologia, as medidas de associação são muito úteis e, mesmo sem falar sobre causalidade, auxiliam na metrificação de como determinada condição de exposição pode aumentar as chances de um desfecho em saúde. Por exemplo, a exposição à fumaça ambiental e desenvolvimento de câncer. O “Odds Ratio”, corriqueiramente traduzido como “Razão de chances”, é a medida de escolha em pesquisas do tipo caso-controle e é apresentado em modelos de regressão logística. Por sua popularidade, resolvi implementar esta análise também nesta aula. Para fazer isso, contei com um outro pacote, que se chama epitools e é bastante simples e dinâmico.

Aula teórica 3: Teste T e lógica inferencial

-vídeo-

Descrição: Quase sempre, nosso interesse em fazer uma pesquisa é conseguir generalizar o que aprendemos pelos resultados amostrais à população de onde aquela amostra foi retirada. Neste vídeo, a partir de uma pesquisa em que verificou-se se havia diferença na quantidade de fala entre homens e mulheres, eu descrevo os passos tradicionais utilizados para inferência em estatística frequentista. É importante alertar que este vídeo não funciona como uma “recomendação padrão” do que você deve fazer antes de partir para inferências, mas sim como um apanhado geral deste tema.

Aula prática 3: Teste T, ANOVA e Tamanho do efeito

-vídeo-

Arquivo utilizado durante a aula: estatistica_r_aula3 Teste T ANOVA

Arquivo complementar: sintaxe_complementar_teste_t (Gráfico da distribuição T e F)

Slide utilizado durante a aula: Estatistica no R – Aula 3 teste T e ANOVA

Descrição: O teste T foi originalmente desenvolvido por William Gosset e publicado em 1908 na revista Biometrika. Quando a variável dependente é normalmente distribuída, o teste T é bastante utilizado para verificar se existe diferença significativa entre dois grupos nesta variável dependente. A ANOVA, por sua vez, expande o teste T para casos em que existem mais de dois grupos. O modelo matemático da ANOVA foi elaborado por Ronald Fisher e foi publicado, em 1921, sob a série intitulada Studies in Crop Variation, no The Journal of Agricultural Science. Nesta aula, ensino como realizar o Teste T, a ANOVA, testes de comparações posteriores e medidas para verificar o tamanho do efeito. Durante este vídeo, aproveito para discutir o problema das múltiplas comparações e sua associação com o erro do tipo 1, bem como explico o motivo pelo qual a ANOVA pode ser vista como uma análise exploratória.

Cinco curiosidades: 1) Gosset não podia usar seu nome nas publicações por conta de uma possível represália de sua empresa (ele era químico e estatístico da Guiness); 2) a revista Biométrika foi fundada em 1901 por K. Pearson, Francis Galton e Raphael Weldon e até hoje é uma das referências mais fortes e estatística e bioestatística. 3) Ronald Fisher e K. Pearson não eram muito amigos e Fisher era obrigado a publicar seus artigos em outras revistas; 4) a publicação da ANOVA generalizou outros conceitos, como o próprio teste T e a Correlação intraclasse ; 5) Fisher era “apenas” mestre (Master of Art Degrees & M.A) nesta época.

Aula teórica 4: Regressão

-vídeo-

Descrição: Se você estudar modelos de regressão, você irá ver que a maior partes dos testes estatísticos pode ser vista como um caso especial ou particular de análises de regressão. Desta maneira, modelos de regressão “substituem” a maioria dos testes que eu ensinei até agora. Fiquei bastante feliz ao ver que não sou o único a pensar que o estudo de modelos de regressão são indispensáveis ao pesquisador: em recente apresentação, Bengt Muthén (um dos autores do software MPLUS e ex-presidente da Psychometric Society) também enfatizou essa necessidade. Neste vídeo, explico sobre sobre esses modelos e mostro o passo-a-passo típico para interpretar os resultados de uma regressão linear múltipla.

Aula prática 4: Regressão

-vídeo-

Arquivo utilizado durante a aula: estatistica_r_aula3 Regressao

Arquivo complementar: sintaxe_complementar_regressao (Gráficos e comparações)

Slide utilizado durante a aula: Estatistica no R – Aula 4 Regressao

Descrição: Modelos de regressão são especialmente úteis para modelar uma variável de desfecho/prevista contínua em função de uma ou mais variáveis explanatórias/preditoras. Neste vídeo, eu mostro como construir modelos de regressão lineares simples (uma única variável) ou múltiplos (duas ou mais variáveis) e como utilizá-los para realizar previsões. A relação bivariada entre a variável prevista e cada uma das variáveis preditoras foi analisada pelo pacote effects. Um aspecto importante – e que eu não abordei neste vídeo – é relacionado à verificação dos pressupostos do modelo, que é feita pela análise dos resíduos. Apesar de nem sempre ser possível cumprir todas as condições de modelos de regressão, é importante verificá-los.

Aula teórica 5: Bayes

-vídeo-

Descrição: Considero que o estudante de Estatística (e de qualquer ciência, no geral), passa por três marcos durante seu desenvolvimento. Todos são muito construtivos e importantes. Nos primeiros anos, percebemos que frases como “isso foi provado!” ou “a ciência comprova isso” são inadequadas, além de potencialmente perigosas. A mecânica da ciência recai em dois pressupostos principais, que são: ela é cumulativa e ela é criteriosa. Em relação a ser “cumulativa”, isto significa que estamos sempre em progresso. Uma pesquisa feita hoje quase sempre é dependente de resultados obtidos por outros pesquisadores. Em relação à palavra “criteriosa”, isto significa que as fontes e os resultados precisam passar por um escrutínio severo antes de serem aceitas (curiosidade: a palavra “critério” é muito utilizada em Teoria de Detecção de Sinal para quantificar a interface entre magnitude de um sinal e intensidade de uma resposta). Tornando este parágrafo longo em algo mais curto, em Estatística, tradicionalmente, assumimos a premissa de que a Hipótese Nula é verdadeira e, portanto, qualquer resultado pode ser melhor entendido como um acaso ou uma sorte. Lembre-se que isso não quer dizer que não acreditamos no método científica,mas apenas que desejamos mais evidências antes de assumir alguns resultados como adequados. Em suma, este primeiro momento é algo frustrante ao início.

O segundo momento ocorre quando estudamos modelos de regressão. Nesta etapa, percebemos que, apesar de não termos certeza (absoluta) dos fenômenos, podemos descrever e predizer razoavelmente bem a relação entre as variáveis que os compõem. Por exemplo, podemos não saber de maneira precisa o quanto determinada terapia auxilia na melhora dos sintomas de depressão, mas podemos prever algumas médias e valores esperados em relação aos sintomas do paciente, bem como controlar o efeito pelo sexo ou idade da pessoa (Outra curiosidade: modelos de regressão que estimam alguns parâmetros controlando por algumas variáveis funcionam como uma saída elegante para pesquisas que não são experimentais e, portanto, tem pouca condição instrumental ao controle de variáveis confundidoras). Este segundo momento é mais tranquilo.

Finalmente, percebemos que aquilo que pergutamos aos dados de uma pesquisa são apenas parcialmente respondidos pela Estatística frequentista. Isso ocorre por um motivo bastante simples de entender: tendo em vista que os modelos assumem que a Hipótese nula é verdadeira, os resultados obtidos pela forma frequentista jamais falam sobre a probabilidade da hipótese de interesse ser verdadeira, mas somente sobre o quanto surpreendente foram os valores alcançados pelos dados, considerando que a Hipótese nula é verdadeira. Evidentemente, há uma mecânica mais elaborada por detrás desta frase, mas que foge bastante do escopo deste texto. Uma das saídas para essa situação é o mergulho na Estatística Bayesiana. Neste framework de trabalho, o pesquisador dá dois importantes saltos teóricos: verifica o quanto uma determinada hipótese é plausível a partir dos dados e estipula um valor a priori para esta hipótese. Este valor a priori não é um salto ao desconhecido, como algumas pessoas acreditam, mas uma condição lógica e calcada em evidências prévias. Por exemplo, em um exame para verificar se uma pessoa tem ou não uma determinada patologia, é necessário levar em consideração a prevalência desta doença na população. Isto vai ser ainda mais importante caso o exame tenha tido um resultado positivo. Este terceiro momento gera sentimentos misturados. De um lado, toda lógica que embasa a Estatística Bayesiana é encantadra; de outro, somos obrigados a rever muitas concepção sobre resultados científicos (além de termos de mergulhar na Matemática). Um livro que conta bem a história do Teorema de Bayes é o “The Theory That Would Not Die”.

Aula prática 5: Aplicação do Teorema de Bayes para dados discretos e contínuos

-vídeo-

Arquivo utilizado durante a aula: estatistica_r_aula5 Bayes

Arquivo complementar: sintaxe_complementar_bayes (Esta é a solução analítica no R) e Solucao analitica Regra de Bayes (Esta é a solução analítica no Excel)

Slide utilizado durante a aula: Estatistica no R – Aula 5 Bayes

Descrição: Imagine que você queira saber como potencializar os efeitos da pílula do dia seguinte (morning after) e, para isso, desenvolva um novo medicamento (RU 476), tal como foi feito originalmente. Para avaliar a efetividade desse novo tratamento em relação ao convencional, será necessário contar com os passos experimentais de sempre: aleatorização, grupo controle vs. grupo experimental e duplo-cego. O próximo passo analítico se este tratamento é superior ao convencional, bem o quanto superior ele é. Ainda nesse cenário, agora imagine que uma determinada mulher, que fez uso de pílula de uma pílula do dia seguinte, tenha tido um resultado positivo em um exame de gravidez. Qual é a probabilidade dela ter feito uso do novo tratamento ? O Teorema de Bayes é uma importante ferramenta estatística para conseguir responder adequadamente a todas essas perguntas. A simplicidade desta formulação esconde o seu poder. Quando consideramos que P(A|B) = P(B|A)*P(A)/P(B), estamos calculando probabilidade de termos determinada hipótese a partir dos dados, o que é bastante diferente da estrutura frequentista de estatística, que cálcula a probabilidade de se obter um conjunto de dados (e, em consequência, uma estatística de teste), considerando a Hipótese nula como verdadeira.

Aula teórica 6: Regressão logística

-vídeo-

Descrição: Modelos de regressão logística tem poucos pressupostos. Basicamente, eles assumem que a que a variável dependente é categórica, que os erros são descorrelacionados e que a amostra é adequada para realizar a modelagem. É facil reparar graficamente que a relação entre as variáveis assemelha-se fora da linearidade, mas, por definição a regressão logística é linear em relação aos seus parâmetros. O aspecto não linear ocorre justamente pela estimação dos coeficientes, que é realizada por métodos de estimação não lineares.

Vale a nota que o termo “variável categórica” aglutina tando uma ideia de “nível de medida”, quanto a ideia de “capacidade informacional da variável”. Em outras palavras, elas incluem variáveis nominais (sexo e profissão) e ordinais (faixa de intensidade de uma dor), quanto variáveis discretas (que não permitem números fracionados), que frequentemente são vistas de maneira binária (sim ou não). Alguns exemplos podem tornam isso mais intuitivo, já que essa relação descritiva de variáveis é quase sempre problemática. Se sua pergunta é qual a relação entre consumo de álcool e acidentes de trânsito (cometeu um acidente ou não cometeu), fica claro que essa variável pode ser entendida como nominal e que os números que iremos atribuir a ela, de forma muito lógica, serão o par binário 0/1. 0 para ausência de acidente) e 1 (presença de acidente). Se a busca é para verificar a probabilidade de uma pessoa desistir do trabalho em função de variáveis como sexo, idade, consumo de drogas, você poderá medir essa probabilidade em faixas, como “baixa”, “moderada” e “alta” e, assim, estará diante de uma variável dependente ordinal.

De forma a resumir isso tudo, é verdadeiro dizer que modelos de regressão logística visam modelar a probabilidade de um evento ocorrer dado/em função de uma ou mais variáveis independentes. Além disso, os termos variam em função da variável dependente, quando binária, “regressão logística binária”; quando mais níveis, “regressão logística multinomial” e “ordinal”.

Aula prática 6: Regressão logística

-vídeo-

Arquivo utilizado durante a aula: estatistica_r_aula6 logistica

Arquivo complementar: sintaxe_complementar_logistica

Slide utilizado durante a aula: Estatistica no R – Aula 6 Regressao logistica

Descrição: Tenha em mente que você queira modelar a relação entre acidentes de trânsito e consumo de álcool. Como vimos, é possível definir acidentes de maneira binária (sim ou não) e verificar os coeficientes dessa relação aplicando a regressão logística. No entanto, para que tudo funcione corretamente, será necessário trabalhar com uma transformação da variável dependente, em que o log é aplicado. Assim, o log(p/1-p) substituirá o y e, por consequência, o resultado não falará sobre “probabilidade”, mas sobre o log da razão de chances de um evento ocorrer. Não é nem difícil retornar à probabilidade, tampouco verificar se o modelo estimado é bem ajustado. Uma curiosidade, apesar de vermos o tempo todo desfechos categóricos (por exemplo, ter ou não uma patológica, repetir de ano ou não, uma máquinha quebrar ou não), essa modelagem é super recente. Atribue-se a David Cox a criação dos modelos logísticos e isso só foi em 1958.

Aula teórica 7: Estatística não-paramétrica

-vídeo-

Descrição: A estatística é uma área incrível e uma das principais características da utilização de técnicas estatísticas é sua capacidade de direcionamento de ações práticas. Por exemplo, nos Estados Unidos, a Food and Drugs Administration (FDA) decide pela aprovação ou não de novos medicamentos com base nos resultados inferenciais. No Brasil, o Banco Central investe pesado em técnicas estatísticas para conseguir investigar condições macroeconômicas. No entanto, para as conclusões terem validade, alguns pressupostos precisam ser observados. Por exemplo, modelos inferenciais frequentemente precisam da normalidade dos resíduos, além de sua independência, etc.

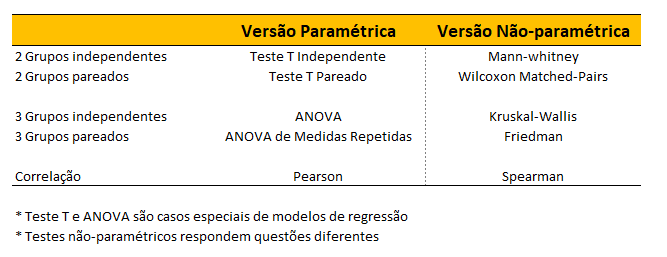

Em muitos problemas cotidianos, os dados apresentam características como multimodalidade, caudas pesadas, etc, que tornam as distribuições usuais inadequadas, preferindo-se assim uma abordagem não-paramétrica para a modelagem da função de confiabilidade em que esta é tratada como uma função completamente desconhecida. Frequentemente, testa-se o formato da distribuição de uma variável com a finalidade clara de eleger um teste de hipótese. Quando percebe-se (visualmente ou via teste de hipóteses) que o formato foge da normalidade, esse resultado é utilizado para eleição de técnicas não-paramétricas. Entretanto, é importante atentar que essa distribuição deve, preferencialmente, ser feita nos resíduos de modelos estatísticos e que algumas ressalvas emergem dessas análises e devem ser apreciadas:

I. As versões não-paramétricas dos testes de hipótese respondem perguntas diferentes! Tenha atenção na escrita dos resultados.

II. A capacidade de adequação prática das inferências torna-se mais limitada, uma vez que trabalha-se com estimadores diferentes da média na maioria das vezes

III. A simbologia utilizada costuma variar de autor para autor e o consenso é pouco provável. Tenha atenção ao reportar estatísticas como tamanho do efeito ou variância explicada.

Posto isso, tenha em mente que o quadro abaixo deve ser usado com bastante cautela e que o Teorema Central do Limite e o Bootstrap são boas saídas na maioria das vezes e podem ser utilizados na maior parte dos dados que temos acesso, mesmo com pequenas amostras.

Aula prática 7: Estatística não-paramétrica

-vídeo-

Arquivo utilizado durante a aula: estatistica_r_aula7 n parametrica

Arquivo complementar: sintaxe_complementar_n_parametrica

Slide utilizado durante a aula: Estatistica no R – Aula 6 N parametrica

Descrição: Entre os conceitos básicos aprendidos em Estatística, temos o de População e amostra. Coletar dados da população é inviável na maior parte do tempo, o que transfere o locus da pesquisa às amostras coletadas da população. Nesse sentido, uma das maiores necessidades que pesquisadores possuem recai na capacidade de generalização (ou inferência) dos resultados adquiridos na amostra. Procedimentos inferenciais podem ser quebrados em dois grandes blocos, paramétricos e não-paramétricos e esse vídeo introduz a modelagem computacional da inferência não-paramétrica.

Notas importantes

- Esta página está em constante atualização. Você deverá retornar aqui toda semana para verificar as novidades e outros materiais até o fim do curso.

- Lembre-se de ajustar as configurações do R e RStudio para que o arquivo seja corretamente conhecido em relação a: vírgulas, pontos, caracteres especiais

- Este é um curso gratuito e introdutório. A vantagem: você não paga absolutamente nada para acessar. A desvantagem: não existe um suporte oficial, mas caso você tenha dúvidas, me mande um e-mail.

Um forte abraço a todos

Um forte abraço,

Luis Anunciação

Psicometria (PUC-Rio)